Conference Debriefing (5a): Wie gefährlich sind Big Data, Künstliche Intelligenz und Algorithmen für den Wettbewerb?

Die steigende Bedeutung von „Big Data“, künstlicher Intelligenz und Algorithmen hat eine intensive Debatte und eine Flut von Konferenzen über die Implikationen für das Wettbewerbsrecht ausgelöst. Anja Rösner vom DICE und Adrian Deuschle vom Lehrstuhl Podszun waren in Brüssel und in Hamburg unterwegs, um herauszufinden, wo die Diskussion derzeit steht. Ihre Debriefings von zwei spannenden Tagungen bringen wir hier im Blog als Doppelschlag – heute berichtet Anja Rösner (@AnjaRoesner) von einer Tagung in Brüssel.

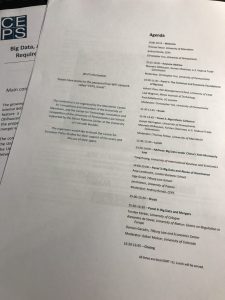

Konferenzname: „Big Data, AI, and Algorithms: Do New Technologies Require New Approaches to Competition Law?”

Ort & Zeit: Brüssel, Centre for European Policy Studies (CEPS), 19.11.2018

Gastgeber: Thomas Fetzer (Mannheim Center for Competition and Innovation), Andrea Renda (CEPS) und Christopher Yoo (Center for Technology, Innovation and Competition der University of Pennsylvania Law School)

Teilnehmer: Wissenschaftler aus den Bereichen Wettbewerbsrecht- und Ökonomie sowie Informations- und Kommunikationstechnologie

Das MaCCI und UPenn treffen sich also in Brüssel, um über Wettbewerb und Digitales zu diskutieren?

Genau, in der Hauptstadt Europas. Das Projekt, dem die Konferenz zugrunde liegt, ist ein gemeinsames zwischen Europa, den USA und China. Gemeinsam will man sich den Herausforderungen des digitalen Fortschritts annähern und die Auswirkungen auf Wettbewerbsbeschränkungen diskutieren. Dabei immer im Hinterkopf: Die Frage nach den Implikationen für das Wettbewerbsrecht in der digitalen Zeit.

Maureen Ohlhausen, ehemalige Kommissarin bei der Federal Trade Commission, startete mit einem interessanten Vortrag über die digitale Entwicklung und deren Auswirkungen auf das Wettbewerbsrecht aus Sicht der USA. Sie machte dabei vor allem eins deutlich, und das zeigt wie spannend und bedeutsam dieses gemeinsame Projekt sein kann: Die Rahmenbedingungen sowohl in gesetzlicher als auch in ökonomischer Hinsicht aller drei Länder bzw. Ländergruppen könnten teils nicht unterschiedlicher sein. Und doch sind alle drei mit den gleichen Problemen konfrontiert, nämlich wie mit Big Data, Algorithmen und künstlichen Intelligenzen (KI) im Rahmen des Wettbewerbs- und Kartellrechts umzugehen ist.

Wie weit sind wir denn technisch und ökonomisch nun mit diesen Technologien?

Während man vielleicht auf die Idee kommen könnte, Big Data würde den heiligen Gral des Handels, nämlich perfekte Preisdiskriminierung zulassen, klärte Ashwin Ittoo, Professor für Informationssysteme an der Universität Lüttich, auf: Nein, Big Data ermöglicht das nicht. Dafür müssten die Daten perfekte Informationen zulassen, was in der Realität nicht passiert. Nichtsdestotrotz kommen Unternehmen mit Big Data definitiv näher an perfekte Preisdiskriminierung als ohne diese technische Möglichkeit (dynamische oder personalisierte Preise sind da nur einige Schlagwörter).

Ein anderes spannendes und aktuell viel diskutiertes Thema sind Algorithmen und stillschweigende Kollusion. Würden KI die Wahrscheinlichkeit für stillschweigende Kollusion erhöhen? Und wenn ja, wie verhalten sich die KI in dieser Umgebung? Ökonomische Theorien zeigen verschiedene Trigger-Strategien bei abweichendem Verhalten. Diese werden auf menschliches Verhalten angewendet. Würden KI genauso handeln oder gäbe es die Rückkehr zu kollusivem Verhalten nach dem Abweichen einer KI? Fragen, die es unbedingt noch zu beantworten gilt, sowohl technisch, ökonomisch als auch rechtlich. Denn stillschweigende Kollusionen sind aktuell legal, nur die Kommunikation zu kollusivem Verhalten ist illegal. Joe Harrington, Professor an der Wharton University of Pennsylvania, hat Forschung dazu betrieben und sich der Frage gewidmet, ob sich neue Möglichkeiten für kollusives Verhalten mit Algorithmen ergeben. Dazu stellt er fest: Kollusion besteht immer aus Belohnung und Bestrafung je nach Verhalten des anderen Unternehmens. Dieses Schema findet nur in den Köpfen und nicht beobachtbar statt. Wir brauchen allerdings Beweise, um illegales Verhalten nachzuweisen. Wenn es also einen Preissetzungsalgorithmus gibt, dann agiert dieser nach einer bestimmten Strategie, die irgendwo sichtbar sein muss. Allerdings, nur weil Algorithmen in der Lage zu kollusivem Verhalten sind, muss das nicht heißen, dass sie es auch durchsetzen.

Big Data ist der Grund für Marktmacht und deren Missbrauch – oder doch nicht?

Daten haben natürlich einen Wert, aber kreieren sie auch einen Wettbewerbsvorteil gegenüber der Konkurrenz? Anja Lambrecht von der London Business School sagt: Nein. Sie begründet ihre Antwort mit der Essential-Facility-Doktrin. Daten, die ein Unternehmen sammelt sind imitierbar, da jeder im Internet auf verschiedene Seiten seinen digitalen Fingerabdruck hinterlässt. Außerdem gibt es genügend Quellen, Daten einzukaufen.

Sind Daten selten? Wohl eher nicht, wenn der digitale Fingerabdruck überall hinterlassen wird. Man suche nur einmal das Geschenk für die Eltern an Weihnachten bei Amazon und Ebay. Vielleicht hat ja noch ein Freund auf Facebook oder Twitter einen Tipp und schon haben alle Unternehmen die gleichen Informationen.

Sind die Daten wertvoll? Ja, aber um deren Wert genießen zu können, braucht es Talent, denn nicht jeder kann sie auswerten. Außerdem kann der Wert trotz der drei großen V‘s (volume, velocity, variety) täuschen. Ein relevanter Punkt ist außerdem die fehlende Kausalität. Häufig fehlen in Big Data exogene Variationen, sodass diese Daten zwar tolle Korrelationen zeigen können, nicht jedoch für kausale Analysen geeignet sind.

Als letzten Punkt gilt es die Frage zu stellen: Sind die Daten ersetzbar? WhatsApp oder Airbnb brauchten, um bestehende Anbieter vom Markt zu drängen, keinerlei Daten, nur eine Idee, die besser zu den Konsumentenbedürfnissen gepasst hat. Und umgekehrt haben Daten Unternehmen wie MySpace trotz bestehender Netzwerkeffekten auch nicht geholfen, sich am Markt zu halten.

Ist Big Data nun also gefährlich oder nicht?

Big Data selbst kreieren keinen wettbewerblichen Vorteil. Allerdings können sich zusammenschließende Firmen durch digitale Cross-Fingerprints durchaus Wettbewerbsvorteile erhalten. Besondere Aufmerksamkeit brauchen daher Merger-Fälle, in denen verschiedene relevante Datenquellen miteinander verknüpft werden können.

Die digitale Zeit stellt in diesem Zusammenhang unser Denken und unsere Definition vom relevanten Markt auf den Kopf. Jan Krämer, Professor für Wirtschaftsinformatik an der Universität Passau, untersucht die Möglichkeit des relevanten Marktes „Aufmerksamkeit“. Je nachdem welches Unternehmen die Aufmerksamkeit des Konsumenten gewinnt, ist es in der Lage, diese einzigartige Marktmacht zu nutzen, um Verbraucherdaten zu sammeln. Mithilfe dieser Daten können neue Produkte entwickelt werden, die wiederum mehr Aufmerksamkeit und mehr Daten produzieren. Während die klassische Marktabgrenzung vor allem funktional ähnliche Produkte in einen einzigen relevanten Markt einschließt, können im Markt für Aufmerksamkeit Produkte wie soziale Netzwerke in denselben Markt eingeschlossen werden wie Online-Videospiele oder Streamingportale.

Was brauchen wir also? Änderungen der Gesetze, mehr Zusammenarbeit zwischen den Ländern?

Was wir noch viel dringender brauchen, ist mehr Forschung auf diesem Gebiet und vor allem das interdisziplinäre Zusammenwirken aus Wissenschaftlern der Rechtswissenschaft, Ökonomie sowie Informations- und Kommunikationstechnologien. Diese sollten sich zum Beispiel der Frage widmen, ob wir neue Schadenstheorien für digitale Märkte brauchen. Da Verbraucher offenbar keinen Schaden verspüren, wenn sie ihre Daten an Unternehmen weitergeben, stellt sich die Frage, wo ist der Schaden?

Wie außerdem die Untersuchungen des Bundeskartellamts im Fall Facebook und auch im neuen Fall Amazon zeigen, gibt es Möglichkeiten mit der aktuellen Gesetzgebung gegen marktbeherrschende Unternehmen im digitalen Zeitalter vorzugehen. Eventuell ist das Gesetz flexibel genug. Wir wissen aktuell aber nicht, wie flexibel es in den kommenden Jahren noch gehandhabt werden muss.

Anja Rössner ist wissenschaftliche Mitarbeiterin am Düsseldorf Institute for Competition Economics (DICE) der Heinrich-Heine Universität Düsseldorf .

One thought on “Conference Debriefing (5a): Wie gefährlich sind Big Data, Künstliche Intelligenz und Algorithmen für den Wettbewerb?”